Preparando su sitio web para la búsqueda con IA mediante llms.txt

En la última década, el SEO (optimización en motores de búsqueda) se ha centrado en motores de búsqueda tradicionales como Google, Bing o Yahoo. Sin embargo, el panorama está cambiando rápidamente. Los avances en sistemas de IA, como ChatGPT, Claude o Perplexity, están transformando la forma en que los usuarios buscan información online.

Cada vez más personas prefieren hacer preguntas en lenguaje natural en lugar de escribir palabras clave, y reciben respuestas precisas y curadas gracias a los modelos de lenguaje (LLMs). Este cambio no es una moda pasajera: es la siguiente etapa en la evolución de la búsqueda digital.

Si su contenido no está optimizado para IA, corre el riesgo de que una parte creciente de los usuarios no lo vea. Para asegurarse de que su contenido sea accesible y se presente correctamente en las respuestas generadas por IA, existe un estándar emergente que debe conocer: llms.txt.

¿Qué es llms.txt y por qué es importante?

Podemos pensar en llms.txt como una guía que indica a los modelos de lenguaje (LLMs) cómo explorar y comprender el contenido de su sitio web. No se trata de un reemplazo ni de una extensión de robots.txt.

Mientras que robots.txt indica a los motores de búsqueda tradicionales qué páginas pueden rastrear, llms.txt ofrece a los LLMs un índice claro y estructurado de su contenido, optimizado para su comprensión.

Funciona como un mapa del sitio web específico para IA, similar a sitemap.xml, pero diseñado para que los bots de IA encuentren, interpreten y utilicen su contenido de manera más eficiente.

Tener un llms.txt preciso y bien organizado puede marcar la diferencia entre aparecer en resultados de IA o quedar fuera por completo.

Búsqueda con IA vs. búsqueda tradicional

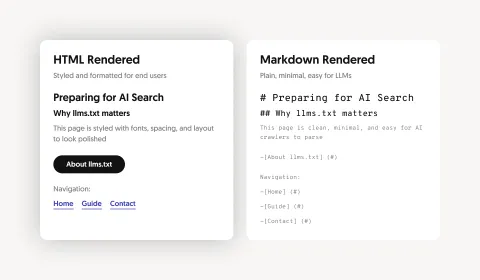

Los LLMs pueden procesar grandes volúmenes de contenido, pero los sitios web saturados con menús de navegación, scripts o anuncios reducen la relevancia y aumentan el riesgo de generar resultados imprecisos. Al ofrecer versiones simplificadas en formato Markdown a través de un archivo llms.txt, se proporciona a los rastreadores de IA un contenido limpio y estructurado, lo que mejora la precisión, preserva el contexto y facilita la indexación y el uso de su información.

Búsqueda tradicional

- Basada en palabras clave y factores de ranking

- Devuelve listas de páginas

- Requiere clics para acceder al contenido

- Depende de sitemap.xml y robots.txt

- Procesa contenido HTML

Búsqueda con IA

- Centrada en contexto e intención

- Entrega respuestas curadas y relevantes

- Proporciona información resumida y sintetizada

- Depende de llms.txt y archivos Markdown limpios

- Procesa contenido en Markdown

Beneficios de implementar llms.txt

- Control: defina qué contenido pueden indexar y mostrar las herramientas de IA.

- Claridad: guíe a los bots hacia el contenido más valioso y fácil de procesar.

- Visibilidad: aumente la probabilidad de aparecer en respuestas generadas por IA.

- Ventaja competitiva: adoptar llms.txt cuanto antes ayuda a mantenerse a la vanguardia de las tecnologías de búsqueda con IA en constante evolución.

Cómo crear y estructurar llms.txt

- Cree un archivo /llms.txt en el nivel raíz en formato Markdown, incluyendo encabezados, resúmenes y enlaces estructurados (por ejemplo: https://example.com/llms.txt).

- Seleccione el contenido clave: elija páginas que representen mejor su sitio web.

- Convierta ese contenido a formato Markdown (.md): ligero y optimizado para crawlers de IA.

- Incluya referencias al HTML original en cada página .md para aportar contexto.

- Organice su llms.txt utilizando listas en Markdown con títulos y descripciones breves:

- # Título del proyecto

- > Breve descripción del proyecto

- ## Sección

- - [Título de la página](https://example.com/page.md): breve descripción

Este formato permite que los LLMs identifiquen, comprendan y accedan rápidamente a su contenido más valioso.

Errores frecuentes y cómo evitarlos

Si convierte su contenido a Markdown para IA, asegúrese de que estos archivos no aparezcan en motores de búsqueda tradicionales. No querrá que alguien buscando su empresa en Google acceda a un archivo .md sin formato.

Opciones para proteger su contenido:

Bloquear archivos .md en robots.txt

Puede indicar a los motores de búsqueda tradicionales que no accedan a los archivos Markdown utilizando su archivo robots.txt:

User-agent: *

Disallow: /*.md$

o, más concretamente:

User-agent: Googlebot

Disallow: /*.md$

User-agent: Bingbot

Disallow: /*.md$

Bloquear archivos .md en su robots.txt impedirá que los motores de búsqueda tradicionales rastreen ese contenido. Los crawlers de LLM no siguen ni respetan robots.txt, por lo que los archivos .md seguirán siendo accesibles para ellos (que es nuestro objetivo real). Tenga en cuenta que este método no garantiza completamente que las páginas no se indexen; solo restringe su rastreo.

Usar encabezados noindex o bloquear crawlers por completo

Puede agregar encabezados de respuesta HTTP para indicar a los motores de búsqueda tradicionales que no indexen páginas específicas:

X-Robots-Tag: noindex

Esto se puede aplicar de manera selectiva según el user-agent, de modo que solo los motores de búsqueda tradicionales reciban la directiva noindex, mientras que los crawlers de LLM permanecen sin restricciones. Para ello, necesitará acceso a su servidor web o a un CDN que soporte encabezados condicionales.

Como alternativa, puede bloquear por completo el acceso de los motores de búsqueda tradicionales a los archivos Markdown. Esto va un paso más allá del noindex, ya que evita que incluso carguen la página. Nuevamente, esto se puede configurar a nivel de servidor o CDN, revisando el user-agent y denegando el acceso.

Cómo lo implementamos en nuestro sitio web

Si utiliza Drupal, la implementación es sencilla con estos módulos:

- llms_txt: genera automáticamente el archivo llms.txt.

- markdownify: convierte el contenido HTML a Markdown limpio.

Con esto, podemos seleccionar qué contenido incluir, convertirlo a Markdown y publicarlo en un formato que los LLMs comprendan fácilmente.

Para mantener el formato Markdown fuera de motores de búsqueda tradicionales:

- Configuramos robots.txt para bloquear el acceso de los motores de búsqueda tradicionales a los archivos en formato Markdown .md.

- Configuramos el CDN para denegar acceso a estos archivos a motores de búsqueda tradicionales.

¿Por qué comenzar ahora?

Los estándares de indexación por IA están evolucionando rápidamente, y quienes adoptan estas prácticas antes obtienen una ventaja competitiva. Actualmente, grandes empresas de IA como OpenAI, Anthropic, Perplexity y otras ya consultan archivos llms.txt al rastrear sitios web (“The value of llms.txt: Hype or real”). Esto significa que, al implementar llms.txt hoy, está preparando su sitio web para el futuro de la búsqueda impulsada por IA.

Cómo podemos ayudarle

Nos especializamos en preparar sitios web para la era de la búsqueda con IA, guiando cada paso de la implementación de llms.txt.

Nuestro equipo le ayuda a seleccionar el contenido más valioso para incluir en su llms.txt, instalar y configurar los módulos de Drupal necesarios y convertir el contenido de su sitio web a Markdown limpio y optimizado para IA.

También le asistimos en la configuración adecuada para garantizar que solo los crawlers de LLM puedan acceder al contenido en Markdown, además de ofrecer soporte continuo mientras evolucionan los estándares de indexación por IA.

Prepare su sitio web para la búsqueda con IA y asegure que su contenido forme parte de las conversaciones digitales del futuro.

Otros artículos destacados

Grabación del seminario web: la IA aplicada al marketing

¿Está pensando en incorporar IA en su estrategia de marketing? Descubra cómo identificar casos de...

Looking into the future of Drupal AI

The future of Drupal is AI-powered. Discover the groundbreaking initiative driving responsible...