Bereiten Sie Ihre Webseite mit llms.txt optimal auf KI-Suchen vor

In den letzten zehn Jahren ging es bei der Suchmaschinenoptimierung (SEO) vor allem um traditionelle Suchmaschinen wie Google, Bing und Yahoo. Aber die Zeiten ändern sich. KI-Systeme wie ChatGPT, Claude oder Perplexity verändern die Anforderungen. Mehr dazu im englischsprachigen Artikel von Kelsey Libert: How AI is reshaping SEO.

Anstatt Schlüsselwörter in eine Suchleiste einzugeben, stellen immer mehr Menschen Fragen in natürlicher Sprache und erhalten passende Antworten von dem entsprechenden Sprachmodell. Dieser Trend wird die nächste Evolutionsstufe der digitalen Suche sein.

Wenn Ihre Inhalte von KI- Suchmaschinen nicht erfasst werden, können sie für viele Nutzer nicht mehr sichtbar werden. Damit Ihre Inhalte in Antworten von KI richtig dargestellt werden, gibt es einen neuen Standard: llms.txt.

Was ist llms.txt und warum ist es so wichtig?

Stellen Sie sich llms.txt als eine Bedienungsanleitung für große Sprachmodelle (LLMs) für den Inhalt Ihrer Website vor. Trotz der Namensähnlichkeit ist llms.txt kein Ersatz oder eine Erweiterung für robots.txt.

Während robots.txt traditionellen Suchmaschinen hilft zu verstehen, welche Seiten sie crawlen können und welche nicht, bietet llms.txt großen Sprachmodellen (LLMs) einen klaren, KI-freundlichen Index Ihres Website-Inhalts.

Sie fungiert als Inhaltsübersicht, ähnlich wie die von traditionellen Suchmaschinen verwendete sitemap.xml, ist jedoch speziell für KI-Bots konzipiert, damit diese Ihre Inhalte leicht finden, verstehen und nutzen können.

Da KI-gesteuerte Suchmaschinen zunehmend an Bedeutung gewinnen, kann eine saubere, genaue und strukturierte llms.txt-Datei darüber entscheiden, ob Ihre Website in den KI-Suchergebnissen aufgeführt wird oder nicht.

KI-Suche im Vergleich zur herkömmlichen Suche

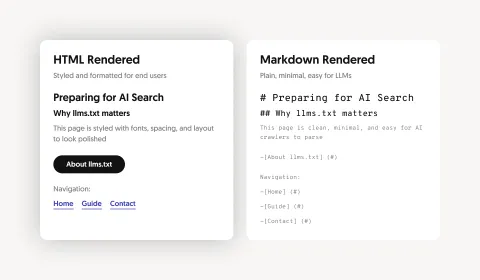

LLMs können zwar große Mengen an Inhalten verarbeiten, aber überladene Websites mit Navigation, Skripten oder Werbung können die Relevanz verringern und Halluzinationen verstärken. Die Bereitstellung abgespeckter Markdown-Versionen über eine llms.txt-Datei bietet KI-Crawlern saubere, strukturierte Inhalte, verbessert die Genauigkeit, bewahrt den Kontext und erleichtert die Indizierung und Nutzung Ihrer Informationen.

Traditionelle Suche

- Stützt sich stark auf Keywords und Ranking-Faktoren

- Gibt Listen von gerankten Seiten zurück

- Benutzer müssen die Ergebnisse anklicken

- Abhängigkeit von sitemap.xml und robots.txt

- Verarbeitet HTML-Inhalte

KI-Suche

- Konzentriert sich auf das Verständnis von Kontext und Absicht

- Liefert strukturierte, hochrelevante Antworten

- Bietet zusammengefasste, synthetisierte Informationen

- Abhängigkeit von llms.txt und sauberen Markdown-Dateien

- Verarbeitet Markdown-Format

Vorteile durch llms.txt:

- Kontrolle: Entscheiden Sie, auf welche Inhalte KI-Tools zugreifen und welche diese indexieren und präsentieren dürfen.

- Klarheit: Übermitteln Sie KI-Bots klare Inhalte, die sie leicht verstehen und analysieren können.

- Sichtbarkeit: Erhöhen Sie Ihre Chancen, in KI-generierten Antworten zu erscheinen.

- Wettbewerbsvorteil: Setzen Sie llms.txt ein, um bei der Entwicklung von KI-Suchtechnologien immer einen Schritt voraus zu sein.

Das llms.txt-Format und Best Practices für die Implementierung

- Erstellen Sie eine „/llms.txt“-Datei im Markdown-Format auf der obersten Ebene, einschließlich Überschriften, Zusammenfassungen und strukturierten Links (z. B. https://example.com/llms.txt).

- Wählen Sie aussagekräftige Inhaltsseiten aus, die Ihre Website am besten repräsentieren.

- Konvertieren Sie diese Seiten in Markdown (.md): schlank und für KI-Crawling optimiert.

- Fügen Sie auf jeder .md-Seite Verweise auf die ursprüngliche HTML-Seite hinzu, um den Kontext zu erläutern.

- Strukturieren Sie Ihre llms.txt mit Markdown-Listen mit beschreibenden Titeln und kurzen Zusammenfassungen:

- # Projekttitel

- > Kurzbeschreibung des Projekts

- ## Name des Abschnitts

- - [Seitentitel](https://example.com/page.md): kurze Vorschau oder Beschreibung

Mithilfe dieses Formats können LLMs Ihre wertvollsten Inhalte schnell identifizieren, verstehen und abrufen.

Markdown-Dateien und die Optimierung für LLMs

Erstellen Sie Markdown-Versionen Ihrer Inhalte für große Sprachmodelle (LLMs) so, dass diese nicht in den Suchergebnissen angezeigt werden. Sie möchten schließlich nicht, dass jemand, der bei Google nach Ihrem Firmennamen sucht, auf eine rohe .md-Version Ihrer Homepage gelangt.

Es gibt einige Möglichkeiten, dies zu vermeiden:

Blockieren Sie den Zugriff auf .md-Dateien in robots.txt

Mit Ihrer robots.txt-Datei können Sie traditionellen Suchmaschinen mitteilen, dass sie nicht auf Markdown-Dateien zugreifen sollen.

User-agent: *

Disallow: /*.md$

oder, noch genauer:

User-agent: Googlebot

Disallow: /*.md$

User-agent: Bingbot

Disallow: /*.md$

Durch die Deaktivierung von .md-Dateien in Ihrer robots.txt-Datei können Sie verhindern, dass herkömmliche Suchmaschinen auf diese Inhalte zugreifen. LLM-Crawler folgen oder respektieren die robots.txt-Datei meist nicht konsequent. Dadurch sind .md-Dateien für sie weiterhin zugänglich, was dem eigentlichen Ziel entspricht. Bitte beachten Sie, dass diese Methode nicht 100% zuverlässig ist, um die Indizierung von Seiten zu verhindern. Sie schränkt lediglich das Crawlen dieser Seiten ein.

Verwenden Sie Noindex-Header oder blockieren Sie Crawler ganz

Sie können HTTP-Antwort-Header hinzufügen, um herkömmlichen Suchmaschinen mitzuteilen, bestimmte Seiten nicht zu indexieren:

X-Robots-Tag: noindex

Dies kann selektiv basierend auf dem User-Agent geschehen, sodass nur herkömmliche Suchmaschinen die Noindex-Anweisung erhalten, während LLM-Crawler davon unberührt bleiben. Dafür ist der Zugriff auf Ihren Webserver oder ein CDN, das bedingte Header unterstützt, erforderlich.

Alternativ können Sie herkömmliche Suchmaschinen vollständig vom Zugriff auf Markdown-Dateien ausschließen. Diese Vorgehensweise geht noch einen Schritt weiter als noindex, da die Seiten gar nicht erst geladen werden. Dies kann auf Server- oder CDN-Ebene erfolgen, indem der User-Agent überprüft und der Zugriff verweigert wird.

Wie wir unsere Website für LLM-Crawler eingerichtet haben

Wenn Sie Drupal verwenden, ist die Einrichtung ganz einfach. Diese beiden Module unterstützen Sie dabei:

- llms_txt: Das Modul erstellt automatisch die "llms.txt" für Ihre Website.

- markdownify: Konvertiert HTML-Inhalte in sauberes Markdown, um das Parsing zu vereinfachen.

Nach der Installation können Sie mit diesen Modulen auswählen, welche Inhalte in Ihre llms.txt aufgenommen werden sollen, diese in Markdown konvertieren und in einem strukturierten Format veröffentlichen, das für LLMs leicht verständlich ist.

Um diese Markdown-Dateien aus traditionellen Suchmaschinen herauszuhalten, sind wir wie folgt vorgegangen:

- Wir haben robots.txt so konfiguriert, dass das Crawlen .md-Dateien durch herkömmliche Suchmaschinen verhindert wird.

- Unser CDN blockiert den Zugriff auf .md-Dateien für herkömmliche Suchmaschinen.

Starten Sie jetzt mit der Implementierung von llms.txt

Die Standards für die KI-Indizierung entwickeln sich ständig weiter. Wer sie früh einsetzt, hat einen Vorteil gegenüber anderen. Große KI-Unternehmen wie OpenAI, Anthropic und Perplexity verwenden beim Crawlen von Websites llms.txt-Dateien. Wenn Sie llms.txt nutzen, sind Sie für die Zukunft der KI-Suche gewappnet. Lesen Sie dazu auch “The value of llms.txt: Hype or real?” von Tiffany Chen auf mintlify.

Wie können wir Sie unterstützen?

Wir sind darauf spezialisiert, Webseiten für die KI-gesteuerte Suche vorzubereiten und begleiten Sie bei jedem Schritt des Implementierungsprozesses von llms.txt.

Unser Team hilft Ihnen bei der Auswahl der wertvollsten Inhalte für Ihre llms.txt-Datei, installiert und konfiguriert die erforderlichen Drupal-Module und konvertiert die Inhalte Ihrer Webseite in sauberes, KI-optimiertes Markdown.

Wir helfen Ihnen auch bei der richtigen Konfiguration Ihres Setups, um sicherzustellen, dass nur LLM-Crawler auf Markdown-Inhalte zugreifen können. Gerne bieten wir auch fortlaufenden Support, da sich die KI-Indexierungsstandards ständig weiterentwickeln.

Bereit, Ihre Webseite für die KI-Suche vorzubereiten? Fangen wir an und sorgen wir dafür, dass Ihre Inhalte von KI-Suchmaschinen berücksichtigt werden!

Weitere Highlights

Aufzeichnung unseres Webinars: Fundierte Entscheidungen über KI treffen

Sie denken über die Nutzung von KI für Ihr Marketing nach? Erfahren Sie in unserem aufgezeichneten...

Ein Blick in die KI-Zukunft von Drupal

Die Zukunft von Drupal ist KI-gestützt: Eine Initiative zur verantwortungsvollen und technisch...